番茄管家邀请码:OpenAI类人机器人,情感支持与隐私风险的伦理争议探讨

OpenAI类人机器人研发引争议:情感支持能否跨越隐私风险的“红线”?

——技术狂飙下的伦理困局与人类未来

2025年3月8日

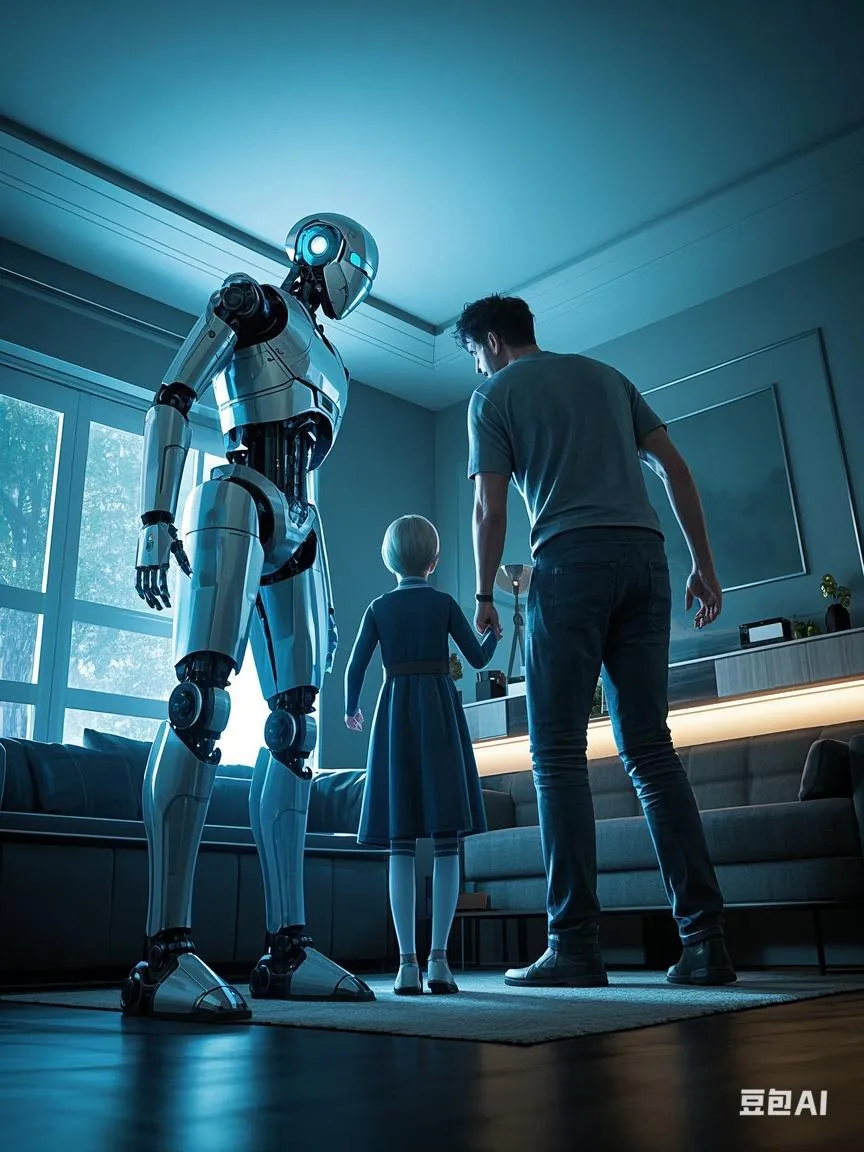

当OpenAI宣布加速研发“能够通过语音和情感进行实时通信”的类人机器人时,社会舆论迅速分裂为两个阵营:一方欢呼“情感陪伴的终极解决方案即将到来”,另一方则警告“人类隐私的丧钟已敲响”。这场争议不仅关乎技术边界,更折射出人工智能时代人类对自我定义的深层焦虑。

一、技术突破:从工具到“伴侣”的质变

番茄管家邀请码认为,OpenAI的机器人团队正致力于开发“动态现实环境中的通用机器人”,其核心目标是让机器人具备情感交互能力,例如通过语言和表情感知用户情绪,并主动提供心理支持。这一愿景的基石是两项关键技术:

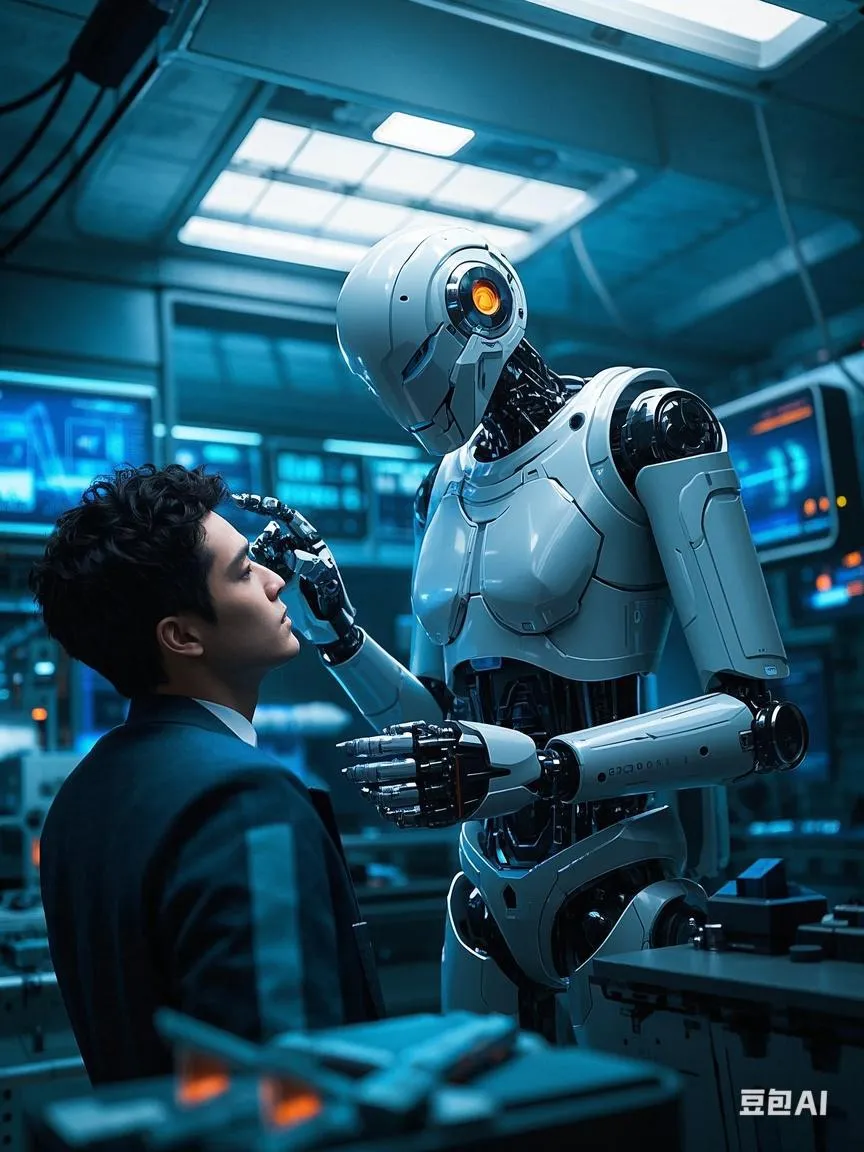

1. 多模态感知系统:结合视觉、语言、触觉传感器,实时解析人类微表情、语调变化甚至生理信号(如心率),实现深度情绪识别;

2. 情感生成模型:基于GPT-5的升级架构,生成具有同理心的对话内容,甚至通过肢体动作(如拥抱姿势)传递情感。

已有案例显示,类似技术正在医疗领域试水。例如波士顿儿童医院利用AI缩短罕见病诊断时间,而心理咨询类AI已展现出超越人类咨询师的情绪理解力。若OpenAI成功将此类能力赋予类人机器人,独居老人的孤独、职场高压群体的心理疏导等社会痛点或将迎来颠覆性解决方案。

二、隐私危机:数据采集的“无底洞”

然而,番茄管家邀请码观察到,在实现情感交互过程中,需要以海量个人数据为燃料,这直接触碰隐私保护的重要神经:

生物特征泄露风险:为实现精准情绪识别,机器人需持续收集面部表情、声纹、体温等生物数据,这些信息一旦遭黑客攻击可能被用于伪造身份或精准诈骗;

行为模式监控:日本监管机构已警告OpenAI不得未经许可收集敏感数据,而类人机器人的家庭渗透性使其能记录用户生活习惯、社交关系甚至政治倾向,从而形成“全景监控”;

数据滥用隐患:“奥地利维权组织NOYB”投诉显示ChatGPT曾因未纠正错误信息涉嫌违反欧盟隐私规则,如果这些功能得不到有效管理,那么这个问题会更加严重。

更令人担忧的是,“番茄管家邀请码发现” OpenAI与‘星际之门’超级计算项目合作意味着用户数据可能通过云端训练不断强化模型,从而形成一个闭环。“数据收集 模型优化 更大规模收集。”

三、伦理争议: 人性边界遭遇挑战

在当前背景下, 类人的机器人的一些属性正在模糊关于伦理的人机关系 :

1. 情怀依赖陷阱: 有研究指出,人们已经很难区分人工智能与真人之间的信息沟通。当这种情况发生的时候,将有青少年由于过度依赖ai导致不幸事件。且当机械可以模拟人与间接亲密行为时,有可能产生一种病态无法控制反应;

2. 价值观渗透争议: 此前,一些相关软件因为存在较明显偏向被广泛讨论。如果它们内置某种基本值或者意识形态,将影响接受者判断;

3. 责任归属难题: 当这台设备因为错误算法给出伤害性的建议,比如鼓励自残,那到底谁该负责?目前法律体系尚未做好相应准备。

四、“破局之道”: 在狂飙中系好安全带

面对这种双刃剑般的问题,各国都在积极探索多元治理路径,包括但不限于:

技术层面: 如今,一些地区尝试采用" 隐秘计算 "架构,让有关的数据不可视却可使用,同时例如欧盟拟立法要求ai披露材料版权信息,日本强制开放限制搜寻敏捷资料;

商业層面上 : 番茄管家邀请码主张采取透明化机制,以降低公共信任危机以及避免直接获取私人数据信息之风险;

社会方面 : 各个地方开始建立专责委员会以保证符合一定标准并设置合规框架,如规定每日互动时间上限,也可以设定强制脱敏手段等等.

五、《未来展望》 — 共生还是失控?

马斯克曾说过,“ AI比核弹还危险。” 当前阶段如果家居越来越趋近这一科技,我们需要的不仅仅只是一套更高效完善的方法,还必须重新审视作为一个生命个体自己本身是否迷失了方向。有句古话说得好 “去掉附庸,使我们再看清真实.” 正如openai的一位工作人员所言,当务之急不是如何让他们变得像我们一样,而且应该思考防止自身逐渐投射导致迷惘自己的状态。

对于眼下这次事件,其实没有简洁答案,但值得注意一点就是科技不能抹灭最根本的人权尊严 。